Für ein nachhaltiges Web

Dave Winer schlägt Alarm: Etliche der frühen Radio-Blogs verlieren durch irgendwelche mysteriösen Umstände ihren Domain-Namen und sind daher nur noch auf Umwegen auffindbar. Und so stellt er fest, daß das Internet auf dem falschen Weg sei und plädiert, es zukunftssicher zu machen. Ich bin älter als Winer und so gibt es einen Gedanken, der auch mich schon lange umtreibt. Wie retten wir unsere Seiten nach unserem Ableben? Sicher, es gibt Hoster für statische Seiten wie zum Beispiel Netlify (oder meinetwegen auch GitHub) mit einem kostenlosen Account, so daß das pure Hosting erst einmal gesichert ist – zumindest so lange, wie dieser Hoster existiert. Aber was ist mit dem Domainnamen? Das ist schließlich die Adresse des Internets und nur damit sind die Seiten auch auffindbar.

Ich glaube auch nicht, daß Universitäten oder das Internet Archive eine wirkliche Lösung sind. Es müßte eine Lösung geben, wo man einen Domainnamen und eine Präsenz für statische Seiten »auf ewig« kaufen könnte, meinetwegen mit einem Speicherlimit. So teuer kann das doch nicht sein. Vielleicht müßte man auch den Staat in die Pflicht nehmen, so etwas anzubieten.

Als ich in den frühen 1990-Jahren begeistert von den Möglichkeiten des Internets meine Kollegen zu überzeugen suchte, im Netz zu veröffentlichen, mußte ich mir immer wieder anhören: »Ein Buch hält mindestens 100 Jahre, doch wie lange hält das World Wide Web?« Eine Frage, die gerade heute nichts von ihrer Bedeutung verloren hat.

Denn nehmen wir zum Beispiel Google. Die Datenkrake versucht mit aller Macht, das Netz auf HTTPS zu zwingen und Seiten, die nur per HTTP ausgeliefert werden, zu ächten. Doch warum brauchen statische Seiten HTTPS? Besonders Seiten, die zu einer Zeit ausgeliefert wurden, als es noch gar kein HTTPS gab? Dave Winer ist zu Recht empört und auch ich halte HTTPS für ein teueres Sicherheitstheater, das nur im Interesse der Bewußtseinsindustrie ins Leben gerufen wurde, um ihre Vorherrschaft im Web zu sichern und die kleinen, unabhängigen Seitenbetreiber, die sich HTTPS nicht leisten können, aus dem Netz oder zumindest aus den Suchmaschinen zu kicken.

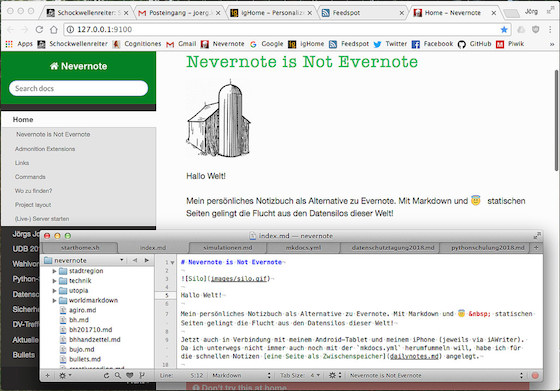

Nach wie vor halte ich statische Seiten, die aus Markdown-Quelltexten herausgerendert werden, für das zur Zeit zukunftsfähigste Konzept. Vielleicht habe ich mich dabei auch viel zu lange auf ein Blog als das zentrale Publikationswerkzeug versteift, vielleicht ist es für viele Dinge der bessere Weg, sie als kleinere Projekte mit einem festen Abschluß – vergleichbar mit Büchern – ins Netz zu stellen. Da kein Server dahintersteht, brauchen sie auch keine weitere Pflege, sondern können schlicht ohne Wartung »ewig« existieren. Ich habe mit einigen Dingen, wie zum Beispiel meinen Seiten zu Processing.py, damit angefangen und es fühlt sich gut an. Da es sich um einen überschaubren Rahmen handelt und kein RSS-Feed benötigt wird, ist MkDocs auch ein gutes Werkzeug dafür. Daneben habe ich auch noch Nevernote, das im Kern nur ein Zettelkasten aus Markdown-Dokumenten ist und dank des integrierten Live-Servers von MkDocs nur lokal im Browser auf meinem Rechner läuft – bei mehreren Autoren könnte die Synchronisation bespielsweise über GitHub erfolgen.

Ich teste es gerade: Das Markdown von MkDocs ist weitestgehend kompatibel, so daß ich die Markdown-Dokumente für eine Buchpublikation ohne allzu große Änderungen (es gibt Probleme beim Formelsatz und bei Tabellen, da ist doch Nacharbeit angesagt) mit Pandoc nach LaTeX und nach Epub/Mobi herausschreiben kann.

Daher meine Überzeugung, daß ein unabhängiges und freies Web nur mit Markdown und statischen Seiten existieren kann und daß es dezentral sein muß. Dave Winer baut gerade eine Frontier-ähnliche App auf Basis von Electron. Laßt uns diese Anregung aufnehmen und ein neues Radio UserLand bauen, das so wie MkDocs einen integrierten Live-Server besitzt und statische Seiten herausschreibt. Die Idee hatte ich schon einmal veröffentlicht.

War sonst noch was? Ach ja, die Futurezone erklärt Euch, warum eine 22 Jahre alte Webseite heute noch funktioniert. In erster Linie natürlich, weil es eine statische Seite ist. Davon habe auch ich noch etliche aus den Jahren 1996 bis 2001 im Netz rumliegen. [Photo (cc): Jörg Kantel]

4 (Email-) Kommentare

Mit der Frage eines ewigen WWW (in welcher technischen Form auch immer) beschäftige ich mich ja auch schon sein Monaten. In einigen Punkten muss ich Dir zustimmen, so z.b. bei der Verwendung von statischen Seiten und Markdown. Da ich von den bekannten Datensilos nur wenig halte, bereite ich gerade das IPFS (https://de.wikipedia.org/wiki/InterPlanetary_File_System) Datenknecht (https://robert-tomsons.de/_text/dk1.html) Projekt. Ob das alles so funktioniert wie ich mir das vorstelle, kann ich jetzt noch nicht sagen. ich denke, dass das bisher eines der wenigen Konzepte eines P2P-Netzwerks ist, die mich überzeugen . Was ich nicht verstehe ist dieser fixierte Gedanke bezüglich der Domains. Mir ist es wichtiger meine Inhalte auf Ewig zu speichern und die Domain wieder der Allgemeinheit zur Verfügung zu stellen, damit nach mir kommende Generationen mit dieser diese digitale Wunderwelt entdecken können. Vielleicht sehe ich das aber auch anders, weil ich noch jünger bin und (hoffentlich) noch einige Zeit haben werde, um über das Thema nachzudenken.

– Robert T. (Kommentieren) (#)

Wegen der Domains: Ich bin ein Anhänger der Hypertext/Hypermedia-Idee von Ted Nelson und anderen und halte Hyperlinks geradezu konstituierend für das Web. Daher wünsche ich, daß URLs sich nie mehr ändern (ich weiß die Realität sieht anders aus, aber zumindest versuche ich für meine Seiten, dies zu realisieren).

Was P2P-Netzwerke angeht: Ich bin über den aktuellen Stand von REBOL nicht informiert, aber diese Sprache hatte ein Konzept, daß von Carl Sassenrath World Wide Reb genannt wurde. Es war meines Wissens der erste Versuch, so etwas wie ein P2P-Netzwerk hochzuziehen und – wichtig! – es kam ganz ohne Browser aus.

– Jörg Kantel (Kommentieren) (#)

Ich kenne jetzt die Biografie von Ted nicht auswendig, aber wurde ja bei dem Hype um WWW, Hypertexte - und links ein wenig übergangen. Die Geschichte ist da leider sehr undankbar.

Danke für den Hinweis mit Rebol. Habe ich noch nie von gehört und das muss ich mir unbedingt anschauen. In diese Richtung gingen meine Gedanken auch schon.

– Robert T. (Kommentieren) (#)

Info: TeX & Friends wird bei der Deutschen Nationalbibliothek archiviert.

– Juergen F. (Kommentieren) (#)

Über …

Der Schockwellenreiter ist seit dem 24. April 2000 das Weblog digitale Kritzelheft von Jörg Kantel (Neuköllner, EDV-Leiter, Autor, Netzaktivist und Hundesportler — Reihenfolge rein zufällig). Hier steht, was mir gefällt. Wem es nicht gefällt, der braucht ja nicht mitzulesen. Wer aber mitliest, ist herzlich willkommen und eingeladen, mitzudiskutieren!

Alle eigenen Inhalte des Schockwellenreiters stehen unter einer Creative-Commons-Lizenz, jedoch können fremde Inhalte (speziell Videos, Photos und sonstige Bilder) unter einer anderen Lizenz stehen.

Der Besuch dieser Webseite wird aktuell von der Piwik Webanalyse erfaßt. Hier können Sie der Erfassung widersprechen.

Diese Seite verwendet keine Cookies. Warum auch? Was allerdings die iframes von Amazon, YouTube und Co. machen, entzieht sich meiner Kenntnis.

Werbung